Existe en la industria un método muy extendido para abordar el análisis de datos, que es el siguiente:

- Recopilar los datos procedentes de todas las fuentes de información relevantes.

- Procesar los datos, incluyendo su limpieza, filtrado y homogeneización.

- Presentar los datos, de manera que sean comprensibles, especialmente de forma gráfica.

- Análizar los datos, extrayendo conclusiones que valgan de forma general a partir de los datos de la muestra.

- Interpretar los resultados, para detectar tendencias y patrones y predecir escenarios futuros.

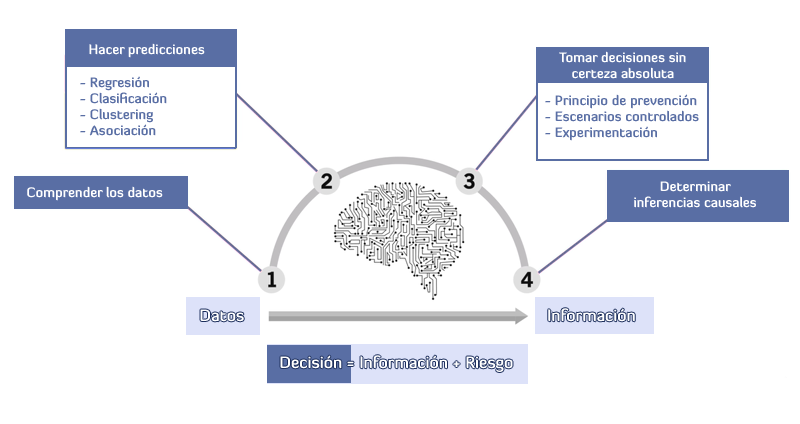

Sin embargo, en Classora hemos mejorado este método a base de experiencia, añadiendo pequeños pasos intermedios:

- Definir las preguntas a responder o, en su caso, los objetivos a perseguir.

- Comprender los datos, no podemos programar un automatismo para que entienda los datos si no lo hacemos nosotros antes.

- Tomar decisiones con incertidumbre, esto implica asumir pequeños riesgos para hacer mediciones en escenarios controlados.

- Establecer inferencias causales, es decir, comprobar si los resultados obtenidos son fruto o no de nuestras decisiones.